【www.zhangdahai.com--其他范文】

乔永坚,刘晓琳,白亮*

面向高维特征缺失数据的K最近邻插补子空间聚类算法

乔永坚1,刘晓琳1,2,白亮1,2*

(1.山西大学 计算机与信息技术学院,太原 030006;

2.计算智能与中文信息处理教育部重点实验室(山西大学),太原 030006)(∗通信作者电子邮箱bailiang@sxu.edu.cn)

针对高维特征缺失数据在聚类过程中面临的因数据高维引发的维度灾难问题和数据特征缺失导致的样本间有效距离计算失效问题,提出一种面向高维特征缺失数据的K最近邻(KNN)插补子空间聚类算法KISC。首先,利用高维特征缺失数据的子空间下的近邻关系对原始空间下的特征缺失数据进行KNN插补;

然后,利用多次迭代矩阵分解和KNN插补获得数据最终可靠的子空间结构,并在该子空间结构进行聚类分析。在6个图像数据集原始空间的聚类结果表明,相较于经过插补后直接进行聚类的对比算法,KISC算法聚类效果更好,说明子空间结构能够更加容易且有效地识别数据的潜在聚类结构;

在6个高维数据集子空间下的聚类结果显示,KISC算法在各个数据集的聚类性能均优于对比算法,且在大多数据集上取得了最优的聚类精确度(ACC)和标准互信息(NMI)。KISC算法能够更加有效地处理高维特征缺失数据,提高算法的聚类性能。

高维数据;

特征缺失;

插补算法;

子空间结构;

聚类

随着科技的不断进步,数据采集设备性能逐渐增强,人们所获取数据的维数越来越高。现实生活中存在很多高维数据,如图像数据、用户评分数据、贸易交易数据、Web文档数据、基因表达数据等。人们可以从这些高维数据中获得更丰富的信息,使各个领域的生产生活更加便利,但是这些高维数据通常具有冗余信息量大、信息分布不均的特点[1],且数据维度过高会造成维度灾难问题[2]。在高维空间下,数据点之间的距离基本相等,使样本间相似性度量方法失效;

同时,高维数据也容易受到噪声和数据缺失问题的影响。因此,高维数据给数据挖掘任务带来了巨大的挑战。

数据在产生和收集过程中,由于某些原因,会出现数据特征缺失的情况,如样本的个别属性值缺失,而高维数据更容易受到数据缺失问题的影响形成高维特征缺失数据。高维特征缺失数据中同样蕴含着丰富的信息,需要人们进行挖掘。聚类分析技术是数据挖掘中的一个重要分支[3],目的是将一组给定的数据依据它们的相似性划分为不同的簇,该划分使得相同簇中的样本尽量相似,不同簇中的样本尽量不同。常见的高维数据聚类算法包括核K‑Means聚类[4]、谱聚类[5]以及子空间聚类[6]等。这些聚类算法已被广泛应用到各大领域中,如生物信息分析[7]、医学图像分析[8]、社交网络[9]、图像分割[10]以及推荐系统[11]等。研究人员可以使用聚类分析技术来挖掘高维特征缺失数据中的隐藏信息,但是这个过程不仅需要解决数据高维引发的维度灾难问题,还要解决数据特征缺失导致的样本间有效距离计算失效的问题,加大了聚类分析的难度。

高维特征缺失数据由于信息不完整,无法使用常见的高维数据聚类算法进行分析。现有的解决方案需要先将高维特征缺失数据插补完整,再对完整的数据进行聚类分析。插补高维特征缺失数据时,受到维度灾难和数据特征缺失导致的样本间有效距离计算失效问题的影响,得到的插补值会扭曲原始数据的潜在结构,使得到的完整数据用于聚类分析时,表现不佳。将高维特征缺失数据补全后,对补全后的完整数据进行聚类分析。如果使用一般的聚类算法,由于没有解决维度灾难问题,在计算样本间相似性时,基于距离的相似性度量方法受到维度灾难的影响变得不可靠,必然会影响最终的聚类结果,所以需要对插补后的完整高维数据进行降维处理。采用矩阵分解法[12]学习高维数据的子空间结构可以解决维度灾难问题,但是得到的子空间结构会受插补算法的影响,因此选择一种合适的插补算法尤为重要。

因此,本文提出一种面向高维特征缺失数据的K最近邻(K‑Nearest Neighbor, KNN)插补子空间聚类(KNN Imputation Subspace Clustering, KISC)算法。该算法主要是将矩阵分解和KNN插补进行有机融合,利用数据的子空间下的近邻关系去插补原数据的缺失特征,通过迭代优化数据的子空间表示和原数据插补值,使子空间结构更加稳定可靠,最终利用稳定的子空间结构去识别数据的潜在聚类结构。最后,在6个高维数据集上对该算法和已有算法进行了实验分析,结果表明本文提出的KNN插补子空间聚类算法非常适合高维特征缺失数据的聚类分析。

现实生活中的大量数据都存在一定程度的缺失,如何对缺失数据进行聚类引起学者们的广泛讨论。目前对高维特征缺失数据聚类需要先进行插补,然后在完整的高维数据集上进行聚类。

已有插补算法可以分为两大类:基于统计学的插补算法和基于机器学习的插补算法。

基于统计学的插补算法运用统计学领域的算法对缺失数据进行处理,如均值插补、冷平台插补、热平台插补、回归插补和模型插补等。Kalton等[13]在热平台插补法的基础上提出树枝分类的距离函数匹配法,使回归插补和热平台插补存在的相关性和回归系数偏差大的问题得到解决。Dempster等[14]提出的期望值最大化(Expectation Maximization, EM)算法在求解缺失值时可以加入求解目标的额外约束。EM算法的不足在于:如果数据集中缺失值的比率过高,EM算法会因为缓慢的收敛和繁琐的计算过程导致估计值与真实值的偏差过大。Little等[15]总结并克服了EM算法的不足,提出了多重插补(Multiple Imputation,MI)法。金勇进[16]介绍了演绎估计、均值插补、随机插补、回归插补和多重插补算法的理论知识。熊巍等[17]结合修正的EM算法,提出了基于R型聚类的Lasso‑分位回归插补法,解决了高维成分数据的近似零值问题。Lux等[18]为任意维度的线性插值提供了一种创新的误差界定,将某些插值技术的性能与常用的回归技术进行了对比,并通过实验结果验证了插值对于中等高维稀疏问题的可行性。

基于机器学习的插补算法借鉴机器学习的各种算法对缺失数据进行处理。武森等[19]针对分类变量不完备数据集定义约束容差集合差异度,直接计算不完备数据对象集合内所有对象的总体相异程度,以不完备数据聚类的结果为基础进行缺失数据的填补,优化了缺失数据的填补效果。陈静杰等[20]通过计算QAR(Quick Access Recorder)数据样本之间的标准欧氏距离选择最近邻样本,利用熵值赋权法计算最近邻的加权系数,基于最近邻样本中燃油流量的加权平均即可得到缺失燃油流量的估计值,有效插补了飞机油耗的缺失数据。Daberdaku等[21]使用特征之间的最大信息系数(Maximal Information Coefficient,MIC)作为距离计算的权重,整合患者自身和患者之间的信息。独立测试线性插值和加权KNN插补算法为每个特性选择最佳的插补方案,通过组合它们进行最终插补,使重症监护室患者多次就诊的纵向临床实验室检测结果的插补效果更显著。陈帅等[22]通过发掘插补过程中非缺失数据的低秩特性,借助奇异值分解理论建立了鲁棒性更强的SVD‑KDR(Singular Value Decomposition‑ Known Data Regression)算法模型,有效减弱了缺失数据对参数估计精度的不利影响,所提算法在高缺失率下仍具有较高插补精度和稳健性。

上述插补算法可以对不同情况的缺失数据进行估计,得到较为准确的插补。但是,由于没有解决维度灾难问题,即使是经过插补的高维特征缺失数据,聚类效果也表现不佳。

为了解决维度灾难问题,需要对高维数据进行降维处理。对数据的降维过程需要满足两个基本条件:一是数据的维度应该减少;

二是需要有效地辨别数据中突出或隐藏的特性。将目标数据集中的数据点按行排列得到由原始数据集构成的数据矩阵,从代数的角度分析,降维可看作是将原始数据点集构成的数据矩阵分解为两个因子矩阵相乘的过程。矩阵分解法[12]即可以对原始数据矩阵进行分解,得到对应的两个低维的数据矩阵,从而实现对原始数据的降维。矩阵分解的过程中,目标数据点集丢失的信息较少,可以较好地保留目标数据中所包含的特征信息,因此可以利用矩阵分解法来学习高维数据集的子空间结构。利用子空间进行聚类可以解决高维数据的维度灾难问题,但是在学习数据子空间结构时,会受到插补信息的影响,当插补信息不适合时,得到的子空间结构用于聚类表现不佳。因此,本文针对高维特征缺失数据提出一种新的插补聚类算法,该算法相较于其他插补聚类算法更加适合聚类分析。

2.1 高维特征缺失数据的插补聚类问题

2.2 KNN插补子空间聚类框架

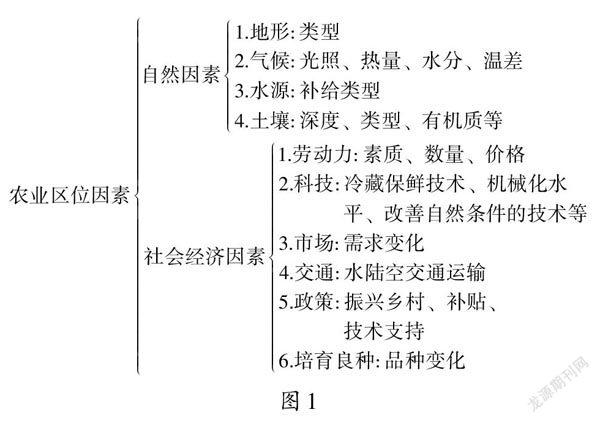

KNN插补算法[23]是一种面向机器学习任务的被广泛使用的数据插补算法。将KNN插补算法用于处理高维特征缺失数据时,由于维度灾难问题和数据缺失导致的样本间距离度量方法失效问题,无法进行有效插补,从而导致聚类效果不佳。为了解决上述问题,本文结合KNN插补算法和子空间聚类算法的优点,提出一种面向高维特征缺失数据的KNN插补子空间聚类算法KISC。该算法的基本思想是:在潜在子空间下,同类数据距离相近,异类数据距离较远,求出高维特征缺失数据的子空间结构可以解决样本间的距离度量失效的问题;

同时,低维结构也能解决维度灾难问题,改善高维特征缺失数据的聚类效果。算法的框架如图1所示。

表1 符号与定义

图1 KISC算法框架

算法的核心步骤如下:

2.3 矩阵分解过程

首先使用矩阵分解算法学习高维特征缺失数据的子空间结构,分解公式如下:

2.4 插补过程

利用式(7)求出子空间下所有数据之间的距离,从而可以得到缺失数据的近邻样本构成的近邻集。为了不被插补的数据误导,本文在插补过程中加入一个约束条件,即:只使用原始数据集中的数据信息进行插补。

2.5 KNN插补子空间聚类算法

学习高维特征缺失数据的子空间结构,可以在子空间下挖掘出数据间的近邻关系,从而解决KNN算法在高维和特征缺失情况下不能计算数据间有效距离的问题。同时,本文固定子空间的基矩阵,充分利用插补信息对子空间的影响,多次迭代KNN插补和矩阵分解过程,逐渐调整数据子空间的系数矩阵,使高维特征缺失数据的子空间结构更加稳定可靠,得到更好的聚类结果。KISC算法的具体流程如下:

根据式(7)计算所有数据间的有效距离;

end

3.1 实验数据

为了验证本文所提算法的有效性,本文选取了6个不同规模的高维数据集。数据集的详细描述如表2所示。

表2 数据集描述

3.2 实验设置

本文实验都是在3.6 GHz CPU,8 GB内存,Windows 10操作系统下完成的,本文算法采用Matlab2018b实现。

将实验对比过程分为两部分:

1)为了证明子空间聚类的有效性,使用0值插补法、最大值插补法、最小值插补法、均值插补法、KNN插补法、EM插补法、矩阵分解(Matrix Factorization, MF)一次插补法共7种插补算法将高维特征缺失数据补全后,直接在数据的原始空间进行聚类分析,并与KISC算法进行比较。

2)为了验证本文算法KISC学到的子空间更适合高维特征缺失数据的聚类分析,使用以下算法与KISC进行比较:①基于统计学的对比算法,包括0值插补法、最大值插补法、最小值插补法、均值插补法、EM插补法。利用这些插补算法将高维特征缺失数据补全后,对完整数据进行矩阵分解得到高维数据的子空间结构,并在该子空间结构进行聚类。②基于机器学习的对比算法,包括KNN插补法、MF法和MF一次插补法。MF法直接使用矩阵分解算法学习高维特征缺失数据的子空间结构,并使用学习到的子空间结构进行聚类。MF一次插补法是在MF法的基础上利用子空间下的近邻关系补全高维特征缺失数据,再次使用矩阵分解学习完整数据的子空间结构,不对子空间进行调整,直接利用子空间进行聚类。MF一次插补法与本文算法KISC的区别在于:直接使用完整数据首次矩阵分解得到的子空间进行聚类,不对子空间结构进行调整。

3.3 评价指标

本文使用的评价指标为标准互信息(Normalized Mutual Information, NMI)和聚类精确度(ACCuracy, ACC)[26]。

3.4 实验结果分析

表3和表4列出了对比算法在6个图像数据集原始空间的聚类性能。结果表明:相较于经过插补后直接进行聚类的对比算法,本文的KISC算法聚类效果更好,这说明子空间结构能够更加容易且有效地识别数据的潜在聚类结构。

表3 在原始空间聚类结果的ACC值比较

表5和表6列出了对比算法在6个高维数据集子空间下的聚类性能。根据聚类效果,可以得出如下结论:

1)在缺失率相同的条件下,0值插补、最大值插补、最小值插补的聚类效果并不稳定,而其他对比算法的聚类效果相对稳定。缺失率为10%时,0值插补和最小值插补在Scene和3Sources数据集上的聚类效果与其他对比算法相近,在其余数据集上的聚类效果相对较差,这与高维特征缺失数据的结构存在联系。当缺失率增加时,0值插补、最大值插补、最小值插补受到很大影响,聚类效果变化较大,而其他对比算法的聚类效果变化小。这说明不同插补信息会对高维特征缺失数据的潜在聚类结构造成不同程度的影响,使用数据的整体信息进行插补聚类,不仅可以改善聚类效果,而且加强了算法的鲁棒性。

2)在算法相同的条件下,不同缺失率的数据对算法的影响不同。MF算法在处理低缺失率数据时,聚类性能与其他对比算法相近,但是当缺失率高于30%时,MF算法的聚类效果急剧下降。说明数据缺失率较高时,只使用已知数据信息不易学到缺失数据的潜在聚类结构。0值插补、最大值插补、最小值插补的聚类性能随着缺失率的增加逐渐下降,这三种方法没有利用样本之间的全面信息,导致插补数据极大程度地扭曲了高维特征缺失数据的潜在聚类结构,缺失率越高,对聚类结构的破坏越大。KNN插补算法的聚类效果相对较好,但是,当数据缺失率过高时,每条数据都会存在不同程度的缺失,无法满足KNN插补算法所需条件,所以该算法部分聚类结果用nan(空值)表示。均值插补、EM插补、MF一次插补和KISC算法使用样本之间的全面信息进行插补聚类,聚类效果较好,并且受缺失率改变的影响较小。

3)KISC算法在各个数据集的聚类性能均优于均值插补、KNN插补和EM插补算法,说明KISC可以更有效地利用数据之间的联系,找到高维特征缺失数据适合聚类的潜在子空间结构。同时,KISC也优于矩阵分解法和矩阵分解一次插补算法的聚类性能,表明迭代插补过程可以优化高维特征缺失数据的潜在聚类结构。本文的KISC算法在大多数据集上的NMI和ACC值都是最优的,表明它可以提升高维特征缺失数据的聚类性能。综上所述,KISC算法更适合高维特征缺失数据的聚类分析。

表4 在原始空间聚类结果的NMI值比较

表5 不同插补算法+子空间聚类算法在子空间聚类结果的ACC值比较

表6 不同插补算法+子空间聚类算法在子空间聚类结果的NMI值比较

3.5 模型分析

3.5.1系数矩阵的收敛性分析

图2 ORL数据集上缺失率为40%时,系数矩阵的变化情况

3.5.2参数分析

图3 ORL数据集上缺失率为40%时,k和对聚类性能的影响

本文针对高维特征缺失数据无法进行有效插补聚类的问题,提出一种面向高维特征缺失数据的KNN插补子空间聚类算法KISC。该算法通过学习高维特征缺失数据的子空间结构,运用子空间下的近邻关系对缺失数据进行有效的迭代插补,并利用插补信息逐渐调整子空间结构,使子空间结构更加稳定可靠,最后使用稳定的子空间进行聚类。在不同数据集上的实验结果显示,该算法在NMI、ACC评价指标上的效果都有所提高,验证了算法的有效性。然而,当缺失数据存在大量噪声时,将缺失数据作为KNN插补子空间聚类算法的输入可能会使聚类精度大幅降低,因此,如何识别出噪声数据,并对缺失数据进行插补和聚类,需要被进一步研究。

[1] CHEN L F, JIANG Q S. An extended EM algorithm for subspace clustering[J]. Frontiers of Computer Science in China, 2008, 2(1):

81-86.

[2] ERTÖZ L, STEINBACH M, KUMAR V. Finding clusters of different sizes, shapes, and densities in noisy, high dimensional data[C]// Proceedings of the 3rd SIAM International Conference on Data Mining. Philadelphia, PA:

SIAM, 2003:

47-58.

[3] WU X D, KUMAR V, QUINLAN J R, et al. Top 10 algorithms in data mining[J]. Knowledge and Information Systems, 2008, 14(1):

1-37.

[4] MULLER K R, MIKA S, RATSCH G, et al. An introduction to kernel‑based learning algorithms[J]. IEEE Transactions on Neural Networks, 2001, 12(2):

181-201.

[5] LUXBURG U von. A tutorial on spectral clustering[J]. Statistics and Computing, 2007, 17(4):

395-416.

[6] VIDAL R. Subspace clustering[J]. IEEE Signal Processing Magazine, 2011, 28(2):

52-68.

[7] LUSCOMBE N M, GREENBAUM D, GERSTEIN M. What is bioinformatics? a proposed definition and overview of the field[J]. Methods of Information in Medicine, 2001, 40(4):

346-358.

[8] RAJENDRAN P, MADHESWARAN M. Hybrid medical image classification using association rule mining with decision tree algorithm[J]. Journal of Computing, 2010, 2(1):127-136.

[9] BEEFERMAN D, BERGER A. Agglomerative clustering of a search engine query log[C]// Proceedings of the 6th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York:

ACM, 2000:

407-416.

[10] SHI J B, MALIK J. Normalized cuts and image segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(8):

888-905.

[11] SHEPITSEN A, GEMMELL J, MOBASHER B, et al. Personalized recommendation in social tagging systems using hierarchical clustering[C]// Proceedings of the 2008 ACM Conference on Recommender Systems. New York:

ACM, 2008:

259-266.

[12] LEE D D, SEUNG H S. Learning the parts of objects by non‑ negative matrix factorization[J]. Nature, 1999, 401(6755):

788-791.

[13] KALTON G, KISH L. Some efficient random imputation methods[J]. Communications in Statistics ― Theory and Methods, 1984, 13(16):

1919-1939.

[14] DEMPSTER A P, LAIRD N M, RUBIN D B. Maximum likelihood from incomplete data via the EM algorithm[J]. Journal of the Royal Statistical Society:

Series B (Methodological), 1977, 39(1):

1-22.

[15] LITTLE R J A, RUBIN D B. Statistical Analysis with Missing Data[M]. 2nd ed. Hoboken, NJ:

John Wiley & Sons, Inc., 2002:200-220

[16] 金勇进. 缺失数据的插补调整[J]. 数理统计与管理, 2001, 20(6):

47-53.(JIN Y J. Imputation adjustment for missing data[J]. Journal of Applied Statistics and Management, 2001, 20(6):

47-53.)

[17] 熊巍,潘晗,刘立新. 稳健高效的高维成分数据近似零值插补方法及应用[J]. 统计研究, 2020, 37(5):

104-116.(XIONG W, PAN H, LIU L X. Robust efficient imputation of rounded zeros in high‑dimensional compositional data and its applications[J]. Statistical Research, 2020, 37(5):

104-116.)

[18] LUX T C H, WATSON L T, CHANG T H, et al. Interpolation of sparse high‑dimensional data[J]. Numerical Algorithms, 2021, 88(1):

281-313.

[19] 武森,冯小东,单志广. 基于不完备数据聚类的缺失数据填补方法[J]. 计算机学报, 2012, 35(8):

1726-1738.(WU S, FENG X D, SHAN Z G. Missing data imputation approach based on incomplete data clustering[J]. Chinese Journal of Computers, 2012, 35(8):

1726-1738.)

[20] 陈静杰,车洁. 基于标准欧氏距离的燃油流量缺失数据填补算法[J]. 计算机科学, 2017, 44(6A):

109-111, 125.(CHEN J J, CHE J. Fuel flow missing‑value imputation method based on standardized Euclidean distance[J]. Computer Science, 2017, 44(6A):

109-111, 125.)

[21] DABERDAKU S, TAVAZZI E, DI CAMILLO B. A combined interpolation and weighted‑nearest neighbours approach for the imputation of longitudinal ICU laboratory data[J]. Journal of Healthcare Informatics Research, 2020, 4(2):

174-188.

[22] 陈帅,赵明,郭栋,等. 基于SVD‑KDR算法的工业监测数据插补技术[J]. 机械工程学报, 2021, 57(2):

30-38.(CHEN S, ZHAO M, GUO D, et al. Missing data imputation using SVD‑ KDR algorithm in industrial monitoring data[J]. Journal of Mechanical Engineering, 2021, 57(2):

30-38.)

[23] GARCÍA‑LAENCINA P J, SANCHO‑GÓMEZ J L, FIGUEIRAS‑ VIDAL A R, et al.nearest neighbours with mutual information for simultaneous classification and missing data imputation[J]. Neurocomputing, 2009, 72(7/8/9):

1483-1493.

[24] 项亮. 推荐系统实践[M]. 北京:人民邮电出版社, 2012:

64-72.(XIANG L. Recommender System Practice[M]. Beijing:

Posts and Telecommunications Press, 2012:

64-72.)

[25] DEZA M M, DEZA E. Distances and similarities in data analysis[M]// Encyclopedia of Distances. 2nd ed. Berlin:

Springer, 2013:

291-305.

[26] XU W, LIU X, GONG Y H. Document clustering based on non‑ negative matrix factorization[C]// Proceedings of the 26th Annual International ACM SIGIR Conference on Research and Development in Information Retrieval. New York:

ACM, 2003:

267-273.

K‑nearest neighbor imputation subspace clustering algorithm for high‑dimensional data with feature missing

QIAO Yongjian1, LIU Xiaolin1,2, BAI Liang1,2*

(1,,030006,;

2(),030006,)

During the clustering process of high‑dimensional data with feature missing, there are problems of the curse of dimensionality caused by data high dimension and the invalidity of effective distance calculation between samples caused by data feature missing. To resolve above issues, a K‑Nearest Neighbor (KNN) imputation subspace clustering algorithm for high‑dimensional data with feature missing was proposed, namely KISC. Firstly, the nearest neighbor relationship in the subspace of the high‑dimensional data with feature missing was used to perform KNN imputation on the feature missing data in the original space. Then, multiple iterations of matrix decomposition and KNN imputation were used to obtain the final reliable subspace structure of the data, and the clustering analysis was performed in that obtained subspace structure. The clustering results in the original space of six image datasets show that the KISC algorithm has better performance than the comparison algorithm which clusters directly after interpolation, indicating that the subspace structure can identify the potential clustering structure of the data more easily and effectively;

the clustering results in the subspace of six high‑dimensional datasets shows that the KISC algorithm outperforms the comparison algorithm in all datasets, and has the optimal clustering Accuracy and Normalized Mutual Information (NMI) on most of the datasets. The KISC algorithm can deal with high‑dimensional data with feature missing more effectively and improve the clustering performance of these data.

high‑dimensional data; feature missing; imputation algorithm; subspace structure; clustering

This work is partially supported by National Natural Science Foundation of China (62022052), Shanxi Basic Research Program (201901D211192), “1331 Project” Quality and Efficiency Improvement Construction Program of Shanxi Province.

QIAO Yongjian, born in 1995, M. S. candidate. His research interests include missing data clustering.

LIU Xiaolin, born in 1990, Ph. D. candidate. Her research interests include machine learning, clustering analysis.

BAI Liang, born in 1982, Ph. D., professor. His research interests include clustering analysis.

1001-9081(2022)11-3322-08

10.11772/j.issn.1001-9081.2021111964

2021⁃11⁃19;

2021⁃11⁃29;

2021⁃12⁃06。

国家自然科学基金资助项目(62022052);

山西省基础研究计划项目(201901D211192);

山西省“1331工程”提质增效建设计划项目。

TP391

A

乔永坚(1995—),男,山西临汾人,硕士研究生,主要研究方向:缺失数据聚类;

刘晓琳(1990—),女,山西太原人,博士研究生,CCF会员,主要研究方向:机器学习、聚类分析;

白亮(1982—),男,山西太原人,教授,博士,CCF会员,主要研究方向:聚类分析。