【www.zhangdahai.com--其他范文】

代胜选,许林峰,刘芳瑜,贺斌

电子科技大学信息与通信工程学院,成都 611731

显著对象检测的目的是在一幅图像中定位并分割出视觉上最具区分性的对象,是一种最基本的计算机视觉任务。深度神经网络兴起以来,显著对象检测受到越来越广泛的关注和研究,并应用于许多计算机视觉任务,例如图像标注(Fang 等,2015)、图像检索(Gao 等,2012)、对象检测(Zhang 等,2016)、语义分割(Huang 等,2018)和行人重识别(Zhao 等,2017)等。显著对象检测经多年发展已出现大量模型,深度学习出现后,模型性能大幅上升,显著对象检测性能每年都有提升。尽管现有的显著对象检测模型的性能已经相当优越,但依旧有很多问题亟待解决,这些问题制约着显著性检测在实际生活中的应用。

基于深度学习的显著对象检测由于具备良好的提取特征语义的能力,能够很好地定位出显著对象的位置,但在完整均匀分割出整个显著对象上还存在一定问题。显著对象检测常作为其他计算机视觉任务的预处理步骤,具有清晰边缘的分割对象,对其后的任务具有十分重要的作用。近年来,显著对象的边缘精确性受到关注,各种模型通过设计各种边缘损失来间接监督显著对象的边缘,以期得到精细的显著边缘。也有模型利用对象特征和边缘特征的互补性来提升对象的边缘细节,但仅在译码阶段进行简单的互补融合,并未充分利用边缘特征,导致边缘提升不明显。考虑到显著对象中显著物体的多样性,包括位置以及尺度的多变性,加强特征的多尺度信息提取十分必要。

针对以上问题,本文提出结合语义辅助和边缘特征的显著对象检测模型。该模型通过语义辅助模块增强相应显著区域的特征强度,得到更为完整和强度均匀的显著对象;

通过边缘特征融合模块提高对象特征在显著对象区域的特征可区分性;

通过设计的双向多尺度模块提取多尺度信息进一步优化特征。本文主要贡献如下:1)设计了语义辅助特征融合模块,在骨干网络提取特征后,该模块根据提取的高层特征生成高层语义,由高层语义选择性地将低层特征融入高层特征,对骨干网络提取的特征进行优化,使各层特征在译码前包含比以前更多的结构信息,增强相应显著区域的特征强度,得到更为完整和强度均匀的显著对象;

2)研究了边缘特征融合模块,通过设计边缘分支显式地监督边缘以得到边缘特征,并通过对象特征改善边缘特征,之后将边缘特征充分融合到对象分支中的各层特征中,提高对象特征在对象边缘区域的特征可区分性,以此提高显著对象的边缘精准性;

3)设计双向多尺度特征融合模块,对同一特征进行多尺度特征提取,使多尺度特征之间的信息相互流动融合,最后获得最具有表现性的尺度特征,能够充分捕获多尺度对象,提高显著对象的检测性能。

显著对象检测的发展分为两个阶段。第1个阶段是基于手工特征和各种先验的传统显著对象检测;

第2个阶段是基于深度学习的显著对象检测。

传统的显著对象检测方法主要是通过设计手工低层特征和利用人类的主观感受与启发式先验来检测显著对象。传统的检测方法利用大量的启发式先验,包括颜色先验、中心先验、全局先验、局部先验、背景先验和中心周围先验等,这些启发式的先验和设计的手工特征在一段时间内促进了显著对象检测的发展。这些直接的技术对保持图像的结构十分友好,但是手工特征先验很难捕获对象的高层语义,导致泛化能力和有效性十分有限,对于场景复杂的图像往往无法得到令人满意的结果。

卷积神经网络能够得到有效的特征表示。早期的深度学习方法利用卷积神经网络提取的特征和全连接层来预测图像块的显著性得分。Zhao等人(2015)提出多上下文显著检测模型,该模型属于一种结合全局上下文和局部上下文的显著对象检测框架。整个框架通过上下两个网络分支分别提取全局和局部上下文。上网络分支的输入是以超像素为中心、包含整幅图像的图像窗口,该分支提取全局上下文;

下网络分支的输入是以超像素为中心、包含图像1/3区域的图像窗口,该分支提取局部上下文。最后通过全连接层结合两个网络分支提取到的上下文特征预测显著谱。Li和Yu(2015)提出基于多尺度深度特征的显著模型,通过3个并列的网络分支提取多尺度特征,利用每个网络分支输入超像素窗口的尺度不同来提取各尺度特征,之后通过两个全连接层融合3种尺度的特征信息,最后通过一个输出层得到显著性输出。卷积神经网络可以自动灵活地提取特征,成功突破了手工特征的瓶颈,使模型获得的性能远优于传统方法。但这些方法以图像块作为卷积神经网络的输入,极其耗时,并且由于全连接层的关系,忽略了输入图像的基本空间信息。

全卷积神经网络(Long等,2015)克服了上述缺点,网络直接将输入图像映射成像素级别的显著性预测,每一个像素点对应一个显著性值,基于全卷积神经网络的方法成为显著对象检测的主流。为了使模型具有丰富的语义以预测显著对象,同时使显著对象的细节依旧丰富,大量模型采用结合高层与低层特征的方法。Hou等人(2017)受边缘检测网络(holistically-nested edge detector,HED)(Xie和Tu,2015)的启发,提出基于深度监督的短连接网络,在网络中从深层向浅层加入短连接,使高层语义特征帮助浅层侧向特征定位显著对象,而浅层特征提供丰富的细节信息。Zhang等人(2017a)提出在各个分辨率上融合各层特征,之后采用从上到下的细化机制得到最后的显著谱,并且在译码过程中提出深度递归监督的学习框架,加强模型性能。Zhang等人(2020)同样采用融合多个尺度的特征进行显著谱预测。Zhang等人(2018a)提出采用双向特征信息流动的方式,并加入了门控单元,在各层信息融合时通过门控单元来控制各层信息流动,使信息更好地融合而滤掉无用信息,同时提出一个多尺度特征提取模块提取多尺度特征来解决图像中物体尺度、形状和定位的多变性。

注意力广泛应用于各种视觉任务,显著对象检测与注意力具有极大关联,近年来注意力也被显著对象检测所采用。Zhang等人(2018b)提出基于渐进注意的递归模型,在译码阶段利用空间和通道注意力提取需要的特征而滤除无用的特征,以避免多余细节干扰而得到次优化的结果,同时采用多路径递归的方式优化特征提取,以提高浅层特征获取全局语义信息的能力。Zhao和Wu(2019)提出的特征金字塔注意模型采用空间和通道注意力,不同于在译码时对所有特征都进行空间和通道注意,而是对高层特征采用通道注意力,对低层特征采用空间注意力,之后再将高层与低层特征融合译码,利用一个内容感知的特征金字塔提取模型来增强高层语义。Liu等人(2018)提出的像素上下文注意模型通过在译码阶段嵌入全局和局部上下文注意模块来提高特征表示能力。陈凯和王永雄(2020)提出一种结合空间注意力的多层特征融合显著性检测模型,用简单的网络结构较好地实现了多层特征的融合与传递。

为了提高检测显著边缘的能力,一些模型提出各种损失函数来监督模型训练,以便得到更好的显著对象边缘。Luo等人(2017)提出一个简单的包含局部和全局信息的卷积神经网络,并应用交并比(intersection-over-union,IoU)损失作为边缘惩罚项来监督模型训练。Qin等人(2019)提出混合损失函数来监督模型训练,包括交叉熵(binary cross entropy, BCE)损失、结构相似度(structural similarity, SSIM)损失和交并比损失。还有一些模型,如Zhao等人(2019)提出根据对象特征与边缘特征的互补性,在译码输出的最后阶段融合对象特征与边缘特征,以提高模型检测边缘的能力。

总体来看,现有的显著对象检测模型已经取得不错的性能,但依旧存在一些问题还未解决。尽管高低层特征融合和注意力的应用使网络特征得到优化,但并没有针对不完整不均匀的显著对象问题设计特定的优化模型,使现有模型依旧面临显著对象不完整不均匀的问题。针对显著对象边缘模糊问题,虽然当前出现了显著对象边缘优化方法,但是这些方法并没有充分利用边缘特征,显著对象边缘改善不大。针对这些问题,本文提出了结合语义辅助和边缘特征的显著对象检测模型。其中语义辅助通过高层语义改善低层特征,而边缘特征融合能够有效增强对象特征的边缘可区分性。之前的方法利用边缘信息主要采用对显著图进行变换后监督边缘的方法,这样一种间接通过显著图得到边缘的方法无法得到足够的边缘信息。之后出现的直接生成边缘图的方法虽然更加直接利用边缘信息,但仅在译码前简单融合对象特征与边缘特征,并没有充分利用边缘信息。在本文中,每一个特征层都会采用语义辅助得到的语义谱和相应的对象特征来优化边缘特征,之后利用边缘特征来增强对象特征的边缘可区分性,通过这样一种方式充分利用边缘信息,得到更好增强边缘的效果。

本文提出了结合语义辅助和边缘特征的显著对象检测网络。该网络通过高层语义辅助处理低层特征,用处理后的低层特征优化高层特征。同时,本文设计的边缘检测分支显式地对边缘特征进行监督和建模,以得到更好的边缘特征;

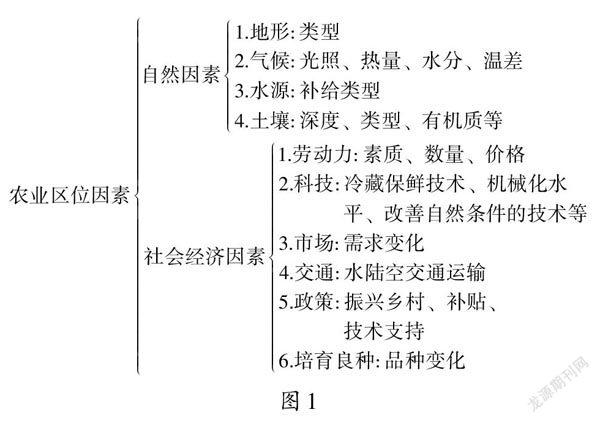

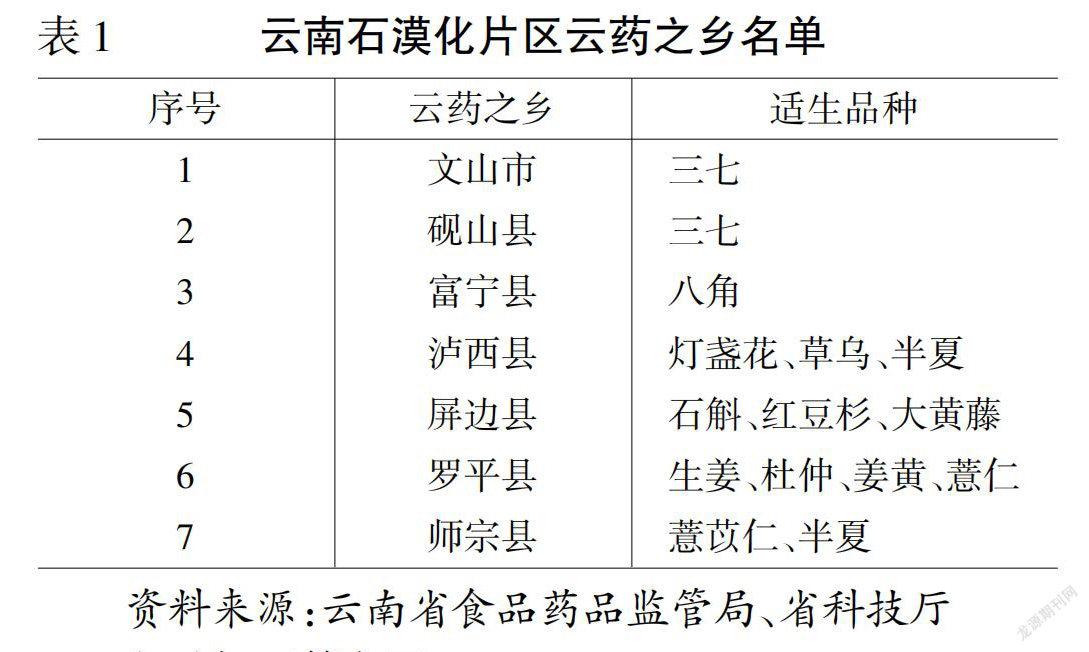

利用边缘分支中的边缘特征增强对象特征中边缘区域的特征可区分性,得到更为完整均匀和精细边缘的显著图。并采用设计的双向多尺度模块提取多尺度信息,进一步优化特征。本文模型的整体框架如图1所示,主要包括特征提取网络的编码模块(encode module,EM)、语义辅助模块(semantic assistant module,SAM)、边缘特征融合模块(该模块由边缘特征生成EGM(edge generating module)和边缘特征融合EAM(edge aggregation module)两部分共同完成)、双向多尺度模块(bidirectional multi-scale,BMS)、译码模块(decode module,DM)。

2.1 特征提取网络

本文模型基于VGG16(Visual Geometry Group)网络(Simonyan和Zisserman,2014)提出。VGG16网络广泛作为显著对象检测网络的骨干网。本文模型去除VGG16网络中最后的两个全连接层和池化层,其余保留VGG16的结构,最终得到的整个骨干网具有5个卷积块,分别为图1中的EM1~EM5。对于一幅尺度为H×W的输入图像,特征提取网络会提取出5层不同分辨率的特征,分别表示为{fi,i=1,…,5},它们对应的分辨率为[H/2i-1,W/2i-1,i=1,…,5]。得到的5层特征含有不同的信息,低层特征分辨率高,具有精细的结构信息;

高层特征分辨率低,包含丰富的语义信息。充分利用特征提取网络提取到的特征,能够得到优越的显著图。

图1 模型的整体框架Fig.1 The overall framework of the model

2.2 语义辅助特征融合模块

为了使各层特征在原有语义信息基础上含有比原有特征更多的结构信息,并使显著区域的特征强度得到加强,本文设计了语义辅助特征融合模块。通过对每两个相邻层特征的分析发现,对于每两个相邻的特征,低层特征中对象的结构性和完整性优于高层特征,往往相邻的低层特征包含高层特征丢失的对象区域和结构信息,而高层特征中有更强的语义信息,显著对象的定位也更为准确,含有更少的背景对象。因此,在译码前,为了使各层特征在包含丰富语义信息的同时能够尽量保留对象的形状结构信息,直观的做法是通过相邻的低层特征中含有的结构信息来补充该高层特征,使该特征同时含有语义和足够的结构信息。而为了更好地增强显著区域的一致性,观察发现,通过高层特征的显著语义能够有效地选择显著区域,从而起到增强显著区域特征和选择融合显著对象结构信息的目的。

为了减少网络的模型参数,对特征提取网络得到的特征进行通道缩减,具体是通过1×1卷积统一将特征缩减到64通道。为了避免出现过多符号,将通道缩减后的特征依然记为{f1,f2,f3,f4,f5},即后文提到的特征{f1,f2,f3,f4,f5}都是缩减通道后的特征。对于之前已经通道缩减后的特征,使用相应的语义选择其相邻的低层特征,以便更好地将低层特征结合到所要优化的特征上。

为了详细说明模块操作的具体流程,以优化特征f3为例,融合相邻低层特征f2来优化本特征。可以将该模块看成左右两部分,分别为获取显著语义和处理低层特征强化高层特征。语义辅助特征融合模块的内部结构如图2所示,语义辅助融合模块用SAM表示。SAM模块的左半部分根据特征{f3,f4,f5}获得显著语义谱S3。具体操作是将特征f4和f5上采样到f3尺度大小,之后级联这3个特征,对级联的特征进行卷积获得所需的显著语义谱S3。显著语义谱S3能提供最基本的显著区域定位信息。模块的右半部分对相邻低层特征f2进行下采样,采样到与特征f3相同的尺度大小。之后通过显著语义谱S3处理相邻的低层特征f2,得到经过处理的低层特征。这里采用像素级相乘处理,意味着重点强化显著区域,主要将低层特征中显著区域的结构细节信息补充到要优化的特征中。经处理的低层特征与特征f3结合,得到优化后的特征fs3。该模块表示为

S3=σ(Conv(Cat(f3,Up(f4),Up(f5))))

(1)

fs3=Conv(Cat(D(f2)⊙S3,f3))

(2)

式中,Cat表示级联操作,将特征沿通道方向进行级联;

Conv表示卷积;

Up表示上采样;

⊙表示像素级相乘;

σ表示sigmoid函数。

图2 语义辅助特征融合模块Fig.2 semantic assistant feature fusion module

对特征f2、f4和f5采用同样的处理方法,经过各自的语义辅助特征融合模块后,能够得到优化后的fs2、fs4和fs5。这样,通过所提出的语义辅助特征融合模块,将骨干网络上提取到的特征f2、f3、f4和f5优化为fs2、fs3、fs4和fs5。相比于原特征f2、f3、f4和f5,经过语义辅助特征融合模块得到的fs2、fs3、fs4和fs5含有更多的结构信息,同时使显著区域的特征更加突出。

2.3 边缘特征融合模块

边缘特征融合模块包括边缘特征生成(EGM)和边缘特征融合(EAM)两个单元。相比于间接通过对象显著图进行边缘监督和在译码阶段显著图输出前简单地利用边缘特征,本文充分利用边缘分支中的边缘特征,加强对象分支中各层特征的边缘信息,提高了特征中显著对象边缘区域的特征可区分性。

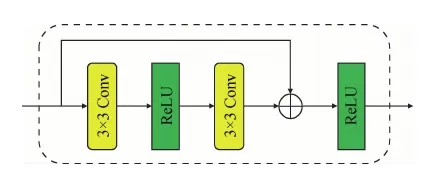

为了充分提取对象的边缘信息,增加了边缘检测分支,通过边缘检测分支中提取的边缘特征加强显著对象检测时的边缘细节。具体地,如图1所示,通过特征提取网络得到的特征f1、f2、f3、f4和f5,经过残差卷积,得到边缘特征fe1、fe2、fe3、fe4和fe5。残差卷积单元如图3所示。

图3 残差卷积单元Fig.3 Residual convolution unit

随后,将得到的边缘特征输入到边缘特征生成单元中,并通过对边缘检测分支进行监督以及对象分支中对象特征信息的辅助,获得更为准确和精细的边缘特征f′e1、f′e2、f′e3、f′e4和f′e5。获得的边缘特征f′e1、f′e2、f′e3、f′e4和f′e5与语义辅助模块处理后的特征fs2、fs3、fs4和fs5经过边缘特征融合单元处理,得到含有精细边缘的对象特征fse2、fse3、fse4和fse5。

边缘检测本来就是一个相对困难的问题,显著对象的边缘检测相比于普通场景的边缘检测,只需要检测出显著对象的边缘而忽略其他对象边缘,完成检测显著边缘的任务。如果只使用骨干网的边缘特征,而不利用显著对象的定位信息,会使得这个任务更加困难。所以本文的边缘特征生成单元用对象特征帮助边缘特征进行显著定位,更有助于检测出显著边缘,这样得到的边缘特征更加精准。之后通过边缘特征融合单元将获取到的边缘特征融入到对象特征中,得到更具有边缘区分性的对象特征。

为了更清楚地描述整个过程,以残差卷积后得到的边缘特征fe3为例进行说明。

在边缘特征生成单元,为了使获得的边缘特征更为精准,在边缘检测中引入对象特征,通过语义辅助模块生成的显著语义谱关注显著对象边缘特征。具体地,为了获得边缘f′e3,将对象特征f3与对应生成的显著语义谱S3像素级相乘,重点传递关于显著区域的对象特征;

接着将已处理的对象特征f3与提取的边缘特征fe3像素级相乘,将对象特征的信息与边缘特征相结合,最后与来自高层的边缘特征f′e4相加,得到要传递给对象分支的边缘特征f′e3。边缘特征生成单元的模型框图如图4所示,表示为EGM。整个边缘生成过程为

f′e3=Conv(f3⊙S3⊙fe3+Up(f′e4))

(3)

式中,f′e3是得到的边缘特征。

图4 边缘特征生成单元Fig.4 Edge feature generating unit

在边缘特征融合单元,结合边缘特征f′e3和经过语义辅助后的fs3,最终得到含有精确边缘信息的对象特征fse3。具体地,将边缘特征f′e3与对象特征fs3级联,随后通过卷积得到fse3。边缘特征融合单元的具体结构如图5所示,用EAM表示。边缘特征融合单元的计算式为

fse3=Conv(Cat(f′e3,fs3))

(4)

图5 边缘特征融合单元Fig.5 Edge feature fusion unit

通过这两部分构成的边缘特征融合模块将原对象特征fs2、fs3、fs4和fs5结合边缘特征变为fse2、fse3、fse4和fse5。该模块提高了对象特征边缘区域的特征可区分性,进而提高边缘精度,减少边缘模糊。

2.4 双向多尺度模块

本文设计的双向多尺度模块以多尺度信息相互交互为基础,同时兼顾特征融合机制,将各个相邻尺度的多尺度特征以一种双向信息传递的方式进行逐步融合。具体地,就是将小尺度特征信息逐步融合进大尺度特征中,同时在另一方向,将大尺度特征信息融入小尺度特征中,通过双向的融合方式实现信息的交互和特征间的融合。整个双向多尺度特征融合模块如图6所示,记为BMS。本文以第5层特征fse5为例进行说明。

如图6所示,输入特征fse5,经过4个分支的处理,分别提取到不同的尺度特征,获得不同感受野的特征。本文模型分支处理与空洞金字塔池化模块(atrous spatial pyramid pooling,ASPP)(Chen等,2017)类似,将特征平均池化为1×1,之后上采样为原特征大小,这里将第1个分支记为fm1。将原特征经过1×1卷积,得到的第2个分支特征,记为fm2。将原特征经过3×3、空洞率为2的卷积,得到的第3个分支特征,记为fm3。将原特征经过3×3、空洞率为4的卷积,得到的第4个分支特征,记为fm4。

(5)

(6)

图6 双向多尺度模块Fig.6 Bidirectional multiscale module

2.5 译码模块

本文模型采用U型结构,对得到的特征f1、fse2、fmse3、fmse4和fmse5进行译码。在这里,将f1记为fmse1,将fse2记为fmse2,将fmse5记为f′mse5,进行从顶到底的译码融合。由于各层特征分辨率的不同,从顶到底采用的具体方式是上采样、卷积、级联和卷积。译码如图7所示,表示为DM。具体公式为

f′mse(i)=Conv(Cat(fmse(i),ConvUp(f′mse(i+1)))),

i=4,3,2,1

(7)

式中,ConvUp表示上采样后卷积。

图7 译码模块Fig.7 Decoding module

3.1 数据集及评价指标

在常用的4个数据集HKU-IS(Li 和Yu,2015)、ECSSD(Yan 等,2013)、DUTS(Wang 等,2017)和DUT-OMRON(Yang 等,2013)上对本文方法进行评价。HKU-IS数据集包含4 447幅高质量像素级别标注的图像,该数据集中的图像至少满足以下标准:有多个不连接的显著对象、至少有1个显著对象接触图像边缘、颜色对比度较低。ECSSD数据集共1 000幅图像,包含许多语义上有意义但是结构复杂的图像。DUTS是当前最大的显著对象检测数据集,由两个子数据集组成,分别是DUTS-TR和DUTS-TE。DUTS-TR包含10 553幅图像用于训练,DUTS-TE包含5 019幅图像用于测试。DUT-OMRON有5 168幅图像,每幅图像中有1或2个对象,大多数前景结构复杂。

采用5个评价指标对实验结果进行评价。分别是查准率(precision,P)—查全率(recall,R)曲线(PR曲线)、MaxF(max F-measure)(Achanta 等,2009)、平均绝对误差(mean absolute error,MAE)(Perazzi 等,2012)、结构性度量(structure-measure,Sm)和增强匹配指标(enhanced-alignment measure,Em)。

PR曲线是评价显著图的一种标准方法,查准率(P)和查全率(R)可以通过二值化的预测显著图和二值真值图得到。由于P和R的计算需要预测图二值化结果,所以通过一系列的阈值将预测图二值化,每一个阈值会产生一对P/R值,通过这一系列的PR值,便可以构建PR曲线。PR曲线越高,表示该模型的检测效果越好,PR曲线越低,表示该模型检测效果越差。

但是查准率和查全率并不能完全评价显著预测的质量,因为高的查准率可能仅强调了显著对象的一部分,如果所有像素被预测为显著性,则高召回率的预测可能毫无意义。通常,高的召回率以降低查全率为代价,反之亦然。因此,F-measure用于同时考虑查准率和查全率,即

(8)

式中,与Zhao等人(2019)方法相同,经验性地设置β2为0.3。

MAE能测量归一化预测显著图S∈[0,1]W×H与真值图G∈[0,1]W×H之间的像素级别绝对误差。具体为

(9)

式中,S是网络的输出显著图,G是真值图,W和H分别表示图像的宽和高。

Sm 测量输出显著图与真值图的结构相似度,主要包含对象感知的结构相似度和区域相似度。

Em同时考虑图像的全局均值和局部的像素匹配。

3.2 实验设置

实验使用单卡的GTX 1080ti完成,提出的网络由PyTorch深度学习框架实现。模型采用VGG 16作为骨干网络,骨干网络部分由在ImageNet上预训练的模型参数初始化,其余所有新加的卷积层以方差0.01、偏差0随机初始化。超参数设置如下:学习率为5E-5,权重衰减为0.000 5,动量为0.9,采用Adam优化器进行学习优化。每10幅图像进行1次反向传播。仅采用随机翻转进行数据增强,输入图像缩放为256×256像素。共训练100个迭代, 60个迭代后衰减为原来的1/10。采用DUTS-train数据集训练模型,没有使用验证集,一直训练模型直至收敛。

模型训练过程中,使用显著边缘图进行边缘分支监督。本文对数据集中的显著对象真值图进行拉普拉斯操作得到显著边缘图。

对显著对象分支进行监督,采用交叉熵损失函数衡量真值图与预测图的误差,损失函数Ls表示为

(10)

式中,G表示显著对象真值图,P表示模型输出的显著图。

对边缘分支进行监督,由于显著边缘真值图中显著像素与非显著像素比例相差太大,所以选择平衡的交叉熵函数,具体为

(11)

式中,β=|E-/E|,1-β=|E+/E|。|E-|和|E+|分别表示非边缘像素集和边缘像素集,Pe表示模型输出的显著边缘图。

模型总损失函数Lo为

Lo=Ls+Le

(12)

在实验过程中,用总的损失函数Lo训练整个模型。

3.3 消融实验

为验证各模块的有效性,对模型的各个模块进行消融实验。模型1是基础模型。基础模型仅包含编码模块和译码模块。模型2是基础模型+语义辅助特征融合模块。该模型在模型1的基础上添加本文提出的语义辅助特征融合模块。模型3是基础模型+语义辅助特征融合模块+边缘特征融合模块。该模型在模型2的基础上添加本文提出的边缘特征融合模型。模型4是基础模型+语义辅助特征融合模块+边缘特征融合模块+双向多尺度模块。该模型在模型3的基础上添加本文提出的双向多尺度模块。

在3种数据集ECSSD、DUT-O和DUTS上衡量这4个模型的性能。模型在4个数据集上的MaxF如表1所示。

1)语义辅助特征融合模块的有效性。通过表1中模型2与模型1的MaxF比较,可以看出,添加语义辅助特征融合模块后,3个数据集的MaxF都得到了提升。相比于基础模型,在ECSSD、DUT-O和DUTS数据集上分别提升了1.6%、3.4%和2.4%,说明了语义辅助融合模块的有效性。实验结果表明,由于语义辅助特征融合模块的结构信息补充和显著区域特征增强,使整个模型检测效果得到提高。

表1 不同模型在3种数据集上的MaxF值对比Table 1 Comparison of MaxF of different models on the three datasets

2)边缘特征融合模块的有效性。通过表1中模型3与模型2的MaxF比较,可以看出,相比于模型2,添加了边缘特征融合模块的模型性能更加优越,各数据集的MaxF提升了0.4%~0.7%。针对边缘的清晰性问题,由于该模块主要通过设计边缘分支以及融合边缘特征实现边缘区域的可区分性,所以数值提升不如语义辅助明显,但是在各数据集上统一的性能提升,可以判断出该网络中边缘特征融合模块的有效性。

3)双向多尺度模块的有效性。通过表1中模型4和模型3的对比,可以看出,检测显著对象的性能得到进一步提高,这主要归功于多尺度信息的提取,说明了双向多尺度特征的有效性。

为了进一步说明本文提出边缘特征融合模块和双向多尺度模块的有效性,将本文模型与其他方法进行对比。

对于边缘特征融合模块,与两种方法进行对比。方法1:直接对显著图进行边缘监督,通过拉普拉斯操作从输出显著图中获取边缘图,对该边缘图进行监督;

方法2:通过低层特征与最高层特征结合得到边缘特征,在最后译码输出显著图前加入到对象特征中。实验结果如表2所示,本文边缘模型相比于现有的边缘模型,得到的性能更好。主要是由于本文通过边缘分支监督边缘,并在各个特征层融入对应边缘特征,充分利用边缘分支产生的边缘特征,提高显著对象边缘区域的特征可区分性,产生的效果更好。

表2 不同边缘方法在3种数据集上的MaxF值对比Table 2 Comparison of MaxF of different edge methods on the three datasets

对于双向多尺度模块,与其他显著对象检测中出现的多尺度模型进行比较。+RFB是在模型3的基础上添加CPD(cascaded partial decoder)模型(Wu 等,2019b)中的RFB(receptive field block)模块。+CFE是在模型3的基础上添加PFA(pyramid feature attention)模型(Zhao 等,2019)中的CFE(context-aware feature extraction)模块。+BMS即模型4,在模型3的基础上添加本文设计的双向多尺度模块。3种多尺度模块在ECSSD、DUT-O和DUTS数据集上的MaxF值如表3所示。可以看出,本文设计的双向多尺度模块BMS相比于RFB和CFE模块,MaxF值提升明显,说明本文设计的双向多尺度模块更有效。

消融实验结果证明了本文设计的语义辅助特征融合模块、边缘特征融合模块和双向多尺度模块的有效性。

表3 多尺度模型在3种数据集上的MaxF值对比Table 3 Comparison of MaxF of multi-scale models on the three datasets

3.4 与现有算法对比

为了客观地评价本文模型,与现有12种算法进行比较。包括ELD(encoded low level distance map)(Lee 等,2016)、UCF(uncertain convolutional features)(Zhang 等,2017a)、NLDF(non-local deep features)(Luo 等,2017)、C2S(contour knowledge transfer for salient object detection)(Li等,2018)、PAGR(progressive attention guided recurrent)(Zhang 等,2018b)、HRS(high-resolution salient object detection)(Zeng等,2019)、MLMS(a mutual learning method for salient object detection with intertwined multi-supervision)(Wu等,2019a)、CAGNet(content-aware guidance for salient object detection)(Mohammadi 等,2020)、GateNet(gated network)(Zhao 等,2020)、MSN(multi-scale network)(张晴 等,2020)、MFSA(multi-level features and spatial attention)(陈凯和王永雄,2020)、HVP(hierarchical visaul perception)(Liu等,2021)。为了公平比较,对比方法的显著图由原作者提供,未提供显著图的方法,结果直接取自原文献。

表4展示了对比方法和本文方法在4种数据集ECSSD、DUT-O、HKU-IS和DUTS上的MaxF值、MAE值、Sm值和Em值。可以看出,在4种数据集上,本文方法的MaxF值高于其他大多数方法或与部分方法接近,特别是在DUT-O数据集上提升明显,在其他数据集上有0.2%~0.3%的提升。MAE低于或与现有方法持平。Sm值和Em值也优于其他方法。这些实验数据说明了本文提出模型的有效性。

图8展示了本文模型与其他模型的显著图视觉比较。如图8第1行所示,本文方法检测的花瓶和花更为完整均匀,有些算法如GateNet算法,虽然检测出了花瓶和花,但是不够均匀,与真值图相比有一定差距,而其他算法甚至无法将花瓶完整检测出来,这说明了本文语义辅助模块检测完整均匀对象的能力。对第2行的人物,本文方法的检测结果同样完整均匀,而其他算法只能检测到人物的一部分躯干。对第3行位于不同位置的汤匙,本文模型能够较好地检测出来,而其他算法检测不全或模糊。这说明了本文多尺度模块的特征提取十分有效。对第4行的蝴蝶,本文方法能够清晰地检测出对象的细节,如蝴蝶头部与尾部。这得益于边缘融合模块的作用。第5行显著对象呈现的特征是细长并且分布广,本文模型相比于其他模型能更好地检测出该类特征的显著对象,保证对象完整并且边缘区域清晰。由于对这种显著对象不明显的场景,大部分显著模型都会将对象和背景检测出来,之后通过设计相应模块来减少背景。本文通过语义辅助和边缘特征融合加强显著对象边缘,由此得到明显对象,但是依然未能将背景全部去掉。可视化结果表明本文模型相比于其他模型更加有效。

表4 不同方法在4种数据集上的MaxF和MAE值比较Table 4 The MaxF and MAE of different methods on four datasets

图8 本文算法与其他算法的显著图比较Fig.8 Comparison of salient maps between our algorithm and other algorithms((a) original images;

(b) ground truth;

(c) ours;

(d) GateNet;

(e) HRS;

(f) PAGR;

(g) C2S;

(h) NLDF;

(i) UCF;

(j) ELD)

图9展示了各种方法在4种数据集上的PR曲线。PR曲线越高,说明模型性能越好。从图9可以看出,本文方法的PR曲线最高,同样表明本文模型较其他对比模型更为有效。

图9 不同算法在4种数据集上的PR曲线Fig.9 PR curves of different algorithms on four datasets ((a) ECSSD; (b) DUT-O; (c) HKU-IS; (d) DUTS)

本文提出一种基于语义辅助和边缘特征融合的显著对象检测模型。为了提高显著对象的整体均匀性,利用高层语义强化低层显著区域的特征,通过高层语义辅助,低层特征与高层特征融合后得到的特征更易检测出均匀的显著对象。通过设计边缘分支得到边缘特征,显式地将边缘特征融合到每一层的对象特征中,增强了对象特征的边缘可区分性,使检测的显著对象边缘更为清晰。同时,设计了双向多尺度模块提取多尺度信息,进一步提高模型性能。在4种公开显著对象数据集上进行验证,得到了优越的性能。

本文利用语义辅助和边缘特征融合的方法取得了优越的显著对象检测性能,但是依然还有不足之处。语义辅助特征融合通过结构信息补充和显著区域增强,对检测出完整均匀的显著对象具有一定的效果,但是当同一对象由不同区域构成,区域间差别非常大且存在明显边缘时,显著对象谱的完整性和均匀性不能很好地表现出来。后续可在本文方法中融合区域与区域的联系和部件结构间关系,从而提高对象的整体性和均匀性。边缘特征融合使显著对象的边缘更加清晰,但是否还有更好的边缘特征与对象特征融合的方法来提高边缘精度,依然值得探究。

猜你喜欢 尺度边缘语义 真实场景水下语义分割方法及数据集北京航空航天大学学报(2022年8期)2022-08-31财产的五大尺度和五重应对内蒙古民族大学学报(社会科学版)(2020年2期)2020-11-06一张图看懂边缘计算通信产业报(2016年44期)2017-03-13宇宙的尺度太空探索(2016年5期)2016-07-12“吃+NP”的语义生成机制研究长江学术(2016年4期)2016-03-11情感形容词‘うっとうしい’、‘わずらわしい’、‘めんどうくさい’的语义分析人间(2015年21期)2015-03-11汉语依凭介词的语义范畴长江学术(2015年1期)2015-02-279时代英语·高三(2014年5期)2014-08-26室外雕塑的尺度雕塑(2000年2期)2000-06-22在边缘寻找自我雕塑(1999年2期)1999-06-28本文来源:http://www.zhangdahai.com/shiyongfanwen/qitafanwen/2023/0607/608410.html