【www.zhangdahai.com--其他范文】

马彦博,李 琳,陈 缘,赵 洋,胡 锐

基于时空融合的多帧压缩视频增强方法

马彦博1,李 琳1,陈 缘1,赵 洋1,胡 锐2

(1. 合肥工业大学计算机与信息学院,安徽 合肥 230601;

2. 苏州科技大学信息化建设与管理中心,江苏 苏州 215009)

为了减少视频的存储和传输开销,通常对视频进行有损压缩处理以减小体积,往往会在视频中引入各类不自然效应,造成主观质量的严重下降。基于单帧的压缩图像复原方法仅利用当前帧有限的空间信息,效果有限。而现有的多帧方法则大多采用帧间对齐或时序结构来利用相邻帧信息以加强重建,但在对齐性能上仍有较大的提升空间。针对上述问题,提出一种基于多帧时空融合的压缩视频复原方法,通过设计的深度特征提取块和自适应对齐网络实现更优的对齐融合,充分地利用多帧时空信息以重建高质量视频。该方法在公开测试集上(HEVC HM16.5低延时P配置)优于所有对比方法,并在客观指标上(峰值信噪比PSNR)相比于目前最先进的方法STDF取得了平均0.13 dB的提升。同时,在主观比较上,该方法也取得了领先的效果,重建出更干净的画面,实现了良好的压缩不自然效应去除效果。

压缩图像复原;

块效应去除;

视频增强;

多帧对齐融合;

可变形卷积

如今,视频已成为数字网络流量的主要部分,且占比仍在不断增长。为了降低传输与存储成本,视频通常需要应用压缩处理技术以大幅降低编码比特率[1]。然而,压缩算法往往会在压缩后的视频中引入各种不自然效应,特别是在带宽严重受限的情况下,可能会显著降低视频质量,影响用户的主观体验。此外,低质量压缩视频中的失真内容还会影响诸如识别、检测等后续视觉任务的研究。因此,压缩视频质量增强的研究具有重要应用价值。

近些年,国内外学者在单幅压缩图像复原方面做了大量工作[2-4]。随着深度学习技术的不断发展,许多基于卷积神经网络(convolutional neural network,CNN)的压缩图像增强工作[5-7]取得了令人印象深刻的结果,其通常以端到端的方式学习非线性映射,从大量的训练数据中直接重建更高质量的图像。但这些方法并不能直接应用于压缩视频的处理,因为单帧方法独立地处理视频帧,并未利用相邻帧之间的时间冗余信息,在去除不自然效应后仍存在较明显的抖动和闪烁伪影,尤其当视频中存在大幅运动时,此现象会更为严重。为了充分利用视频序列的时间相关性,YANG等[8]首次提出了一种多帧质量增强方法MFQE1.0 (multi-frame quality enhancement),利用压缩视频中的高质量帧作为参考帧并通过多帧CNN来提高相邻低质量帧。此外,GUAN等[9]利用升级版的MFQE2.0进一步提高了多帧CNN的效率,取得了更好的效果。为了解决视频中存在的运动误差,主流的多帧方法均使用了时间融合方案,结合密集光流来进行运动补偿[10-11]。然而,压缩块效应可能会严重扭曲视频内容并破坏原有相邻帧之间的像素对应关系,很难学习到精准的运动光流场,从而导致无效的质量增强,反而会严重影响网络的性能。DENG等[12]使用可变形卷积(deformable convolution,DCN)[13]来自适应地进行时空位置采样,捕捉相关上下文以聚合其之间信息,同时避免显示光流估计。然而,该方案直接在视频帧上进行自适应采样并简单地通过视频帧并联进行帧重建,未充分挖掘相邻帧的深度特征信息和时序信息。

受文献[12]的启发,本文提出一种深度时空特征融合的多帧质量增强方法,通过所设计的深度特征提取块高效提取空间信息并进行成对对齐,同时使用带有注意力机制的融合模块对相邻帧逐步融合以充分利用时序信息重建高质量视频。

1.1 基于单帧的图像质量增强

近年来,多数工作都集中在图像质量增强上。文献[2]应用逐点形状自适应离散余弦变换减少JPEG压缩引起的振铃和块效应。Jancsary等[14]采用回归树场(regression tree fields,RTF)降低JPEG图像分块效应。此外,CHANG等[15]还尝试利用稀疏编码去除压缩块效应。随着深度学习的发展,基于CNN的端到端方法实现了更先进的性能。文献[5]首先使用4层的浅层卷积去除各类JPEG不自然效应。ZHANG等[16]利用残差学习方案,并尝试学习非常深的网络取得了更优的效果。文献[7]则通过更深的网络和非局部注意力机制捕捉像素间的远程依赖关系从而恢复更高质量的画面。上述所有单帧图像质量增强方法直接应用于视频质量增强而忽略了相邻帧间的时序相关性,只关注当前帧有限的空间信息使其在视频质量增强上的性能受到了限制。

1.2 基于多帧的视频质量增强

连续的视频帧往往是高度相关的,除了利用当前帧的空间信息,视频序列的时序信息的合理利用也是进一步提高重建质量的关键。MFQE1.0率先应用多帧CNN并同时利用时序信息进行压缩视频质量增强,即用视频序列中的高质量帧来提高相邻低质量帧的质量。首先通过支持向量机(support vector machine,SVM)分类器遵循无参考质量评估方法[17]对压缩视频帧进行质量划分,将局部最高质量帧称为峰值质量帧,2个峰值质量帧之间的其他帧称为非峰值质量帧,再运用显示光流对2个峰值质量帧进行运动估计以尽可能地利用相似信息对非峰值质量帧进行补偿和增强,取得了比以往大部分单帧方法更好的结果。文献[9]提出的MFQE2.0在升级了MFQE1.0的几个关键组件后取得了更优的性能。但上述方法在很大程度上依赖精准的光流估计,而由于遮挡,受大运动或特定的压缩块效应之问题的影响,很难获得精确的光流。受视频超分领域[18-19],即利用DCN[13,20]隐式运动对齐的启发,文献[12]以目标中间帧和相邻帧为输入联合预测可变形卷积偏移并在单个可变形卷积中进行对齐融合来聚合时空信息,以此省略了对光流的显示估计。然而该方案直接对视频帧进行融合重建,一定程度上减少了计算量,但仍未充分挖掘视频帧中包含的空间信息和时序信息,在细节重建上仍存在不足。本文通过深度特征提取块进行特征信息提取,以充分挖掘帧序列中的空间特征,减少信息损失,并在特征图层面利用DCN进行对齐,同时利用带有注意力的逐步融合策略逐步融合相邻帧以更好地整合时序信息从而重建更高质量的结果。

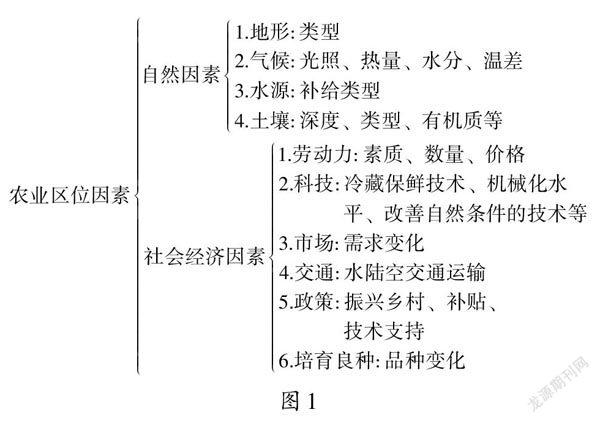

在给定压缩视频包含复杂不自然效应的情况下,所提方法的目标是去除这些不自然效应,尽可能提高视频质量。如图1所示,本文方法主要由3个阶段组成。首先,中间帧与前后若干相邻帧一同输入特征提取阶段提取帧空间特征;

其次,在对齐融合阶段,按时序对齐相邻帧特征获取融合特征;

最后,通过重建阶段进一步增强时空融合特征,以改善图像细节并生成高质量的中间帧。

图1 整体结构图

2.1 深度特征提取

极深CNN在图像增强类任务中呈现出强大能力,而图像特征信息的获取,为网络后续的重建提供了基础,在该阶段,5个连续的低质量压缩输入帧首先通过一个大小为3×3的卷积层进行特征升维,再投入到深度特征块进行充分的空间特征提取,可表示为

其中,为输入帧;

为提取的特征;

为中间帧索引;

为相邻帧索引;

3表示3×3卷积;

为深度特征提取块。

在CNN中,残差连接对提高网络性能起着至关重要的作用。随着网络容量的不断增加,深度残差特征逐渐集中在输入图像的不同方面,对于重建空间细节是非常有用的。为了充分利用残差分支中不同的层次特征,减少信息损失,本文提出一种密集残差特征聚合结构,称之为深度特征提取块(deep feature extraction block,DFB),以提高深度特征提取的效率,其具体结构如图2所示。该模块由若干3×3卷积层,1×1卷积层和ReLu激活层组构成,特征维度为32。特别的,本文将卷积操作后得到的特征图输入该模块进行不同深度的再提取,不同层次的输出分支会交叉地进行密集连接和传递,每组输入前还会通过1×1卷积进行通道降维以减少计算量。与简单的堆叠多个残差块相比,本文模块可以更高效地利用和传播分层特征信息,从而获得更具区分性的特征表示。

图2 深度特征提取块结构图

2.2 对齐融合

相邻帧特征包含了丰富的时间冗余信息,不同位置的差异化特征都有可能对重建的细节产生增益,但不同帧之间往往存在一定的运动差异,为了有效利用时序信息,需要对其进行对齐处理。以往的视频增强方法大多基于光流对齐[11,21]或采用3D卷积进行时间跨度采样[22],对于压缩视频增强任务,这些方法均是次优的。除了常见的遮挡和大运动等干扰情况,压缩视频中往往还包含各类复杂不自然效应,大大增加了学习准确光流的成本和难度,而不准确的光流估计会严重影响模型的后续性能。此外,还有些方法使用多个堆叠的3D卷积进行时空信息聚合,造成了极大地计算负担,使得模型难以训练并影响了整体效率。对此,本文采用在视频超分等任务中被广泛采用的DCN隐式对齐来替代显示的光流对齐。不同于STDF[12]直接对帧进行对齐融合,本文在特征层面进行成对的自适应偏移学习,获得更丰富的时空信息表征,以充分地学习相邻帧之间的运动信息。

对于特征提取阶段获得的连续帧特征,本文依次将相邻特征和中间参考帧成对投入偏移学习网络学习对齐所需的偏移量,即

其中,D为所学习的偏移量;

(*)为偏移学习网络;

[,]为并联操作。偏移学习网络结构如图3所示,遵循通常在光流估计中采用的多尺度方法[23],相邻的一组特征在所设计的Unet模块中进行多次下采样和上采样,以便用更大的感受野和多尺度动态处理小位移和大位移,预测更合适的偏移。其中下采样单元利用空洞为2的3×3卷积进行下采样,上采样单元利用双线性插值进行特征放大。对于学习到的偏移DP+r,利用DCN对对应的相邻特征F+r进行对齐,即

其中,为DCN对齐操作;

A+r为对齐后的对齐特征。

由于压缩视频中不同帧之间存在质量波动,简单的卷积聚合可能无法起到很好的效果,为了更高效地利用对齐后的特征,本文提出一种带有通道注意力的逐步融合模块,采用逐步融合的方式来感知不同帧特征之间的质量差异,从而有效地进行时间聚合。图4中,上一步骤输出的5帧对齐特征以局部连接的方式每3个一组投入到2层融合模块中,通过多次局部融合获得中心输入帧对应的融合特征。每组局部融合操作为

图3 对齐模块结构图

图4 逐步融合模块结构图

其中,1为1×1卷积,用以通道降维;

为由3个包含注意力层的残差块堆叠而成的融合块。特别的,通道注意力采用ECA[24]的方案。每一层融合模块共享参数,从而降低了模型对内存的要求。

2.3 图像重建

最后,重建融合特征网络,其作用是挖掘融合后特征中的互补信息,进行进一步细节增强,并将信息从特征空间映射到图像空间。此外,为了减少信息损失,重建后的增强特征还需与对齐融合阶段得到的融合特征进行了残差连接,即

其中,R为上一阶段得到的融合特征;

为2个深度特征块,其结构与特征提取阶段所用模块相同;

1为1×1卷积;

O为输出的重建图像。

3.1 数据准备

本文实验采用基于MFQE2.0提出的数据集,从XIPH (xiph.org)和VQEG (VQEG) 2个数据库中收集了108个不同分辨率和内容的未压缩视频用于训练。为了验证实验结果,将来自视频编码联合协作团队的数据集[25]用于测试,同时用于视频质量评估。由于实验GPU性能受限,无法对分辨率大于或等于1920×1080视频序列进行直接测试,因此只选用其余11个不同分辨率未压缩视频,每个视频大约500帧。训练视频和测试视频均使用最新的H.265/HEVC[26]参考软件HM16.52在低延时P (low delay P,LDP)配置下进行压缩,其中压缩量化系数(quantization parameter,QP)设置为37。

3.2 实验设置

本文算法实现框架为PyTorch。从原始视频和对应的压缩视频中随机裁剪尺寸为64×64的图像块作为训练图像,同时,采用旋转、翻转等基本数据增强手段以扩充训练样本。网络训练使用ADAM优化器,其各参数采用默认值1=0.9,2=0.99,=10-8。多帧压缩视频增强网络采用端到端方式进行训练,批量数据规模设置为16,学习率参数初始化为10-4。网络中使用的卷积核为3×3(涉及通道降维的卷积核为1×1),特征通道数设置为32(重建模块为48)。训练采用的损失函数为Charbonnier函数[27],即

其中,参数基于经验设置为10-3,通过引用该参数,可以更好地保留图像边缘信息以避免模糊,同时有益于网络稳定收敛,该损失函数已被广泛用于各类图像视频增强任务。与以往工作相同,本文只对YUV空间中的Y通道(即亮度分量)进行质量增强。并采用增量峰值信噪比PSNR和结构相似性SSIM测量增强视频相对于压缩视频的改善,并从参数量和主观图像等方面对本文方法进行评估和分析。

3.3 实验分析

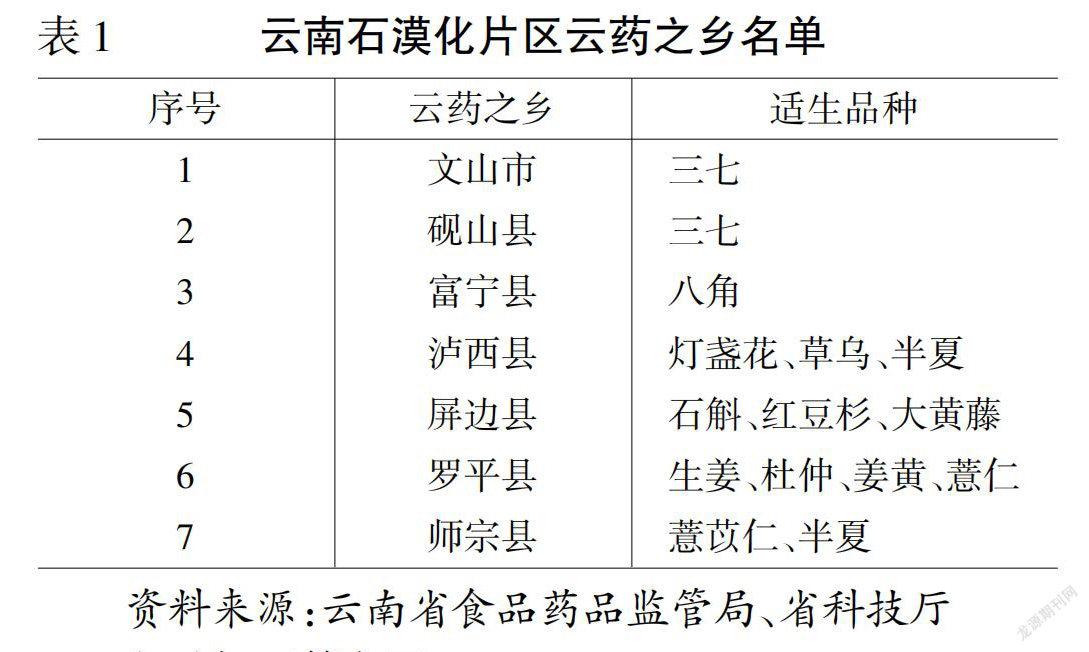

将本文方法与目前最先进的压缩/视频质量增强方法DnCNN[16],RNAN[7],MFQE1.0,MFQE2.0和STDF进行比较,所有方法均在相同的数据集上进行训练和测试。表1为实验结果,其中DnCNN和RNAN是先进的单帧压缩图像质量增强算法,由于只利用了当前低质量帧的有限信息,增益较为有限,多帧方法聚合了相邻帧空间位置上更丰富的时空信息,在测试序列上普遍表现出优于单帧方法的性能。结果表明,本文方法在多种压缩量化系数下均取得了最高增益,其中,在压缩量化系数为37时,相较于先进的多帧方法STDF平均PSNR提升了0.13 dB。值得一提的是,DnCNN和MFQE2.0均为轻量方法,较浅的网络带来了优异的推理速度。而STDF在空间域直接对输入帧进行融合和重建,节省了更多计算量,本文方法则强调更有效的对齐融合,在控制参数量的同时获得了更高的性能提升。

表1 QP = 37时在不同测试序列上的各算法ΔPSNR(dB)/SSIM(×10-2)比较

注:加粗数据为最优值

图5给出了不同方法增强后图像的主观质量比较。通过观察可知,对于原始压缩帧图像,单帧方法效果有限,无法很好地去除其中的压缩块效应,在给定包含运动的画面中,多帧方法能从相邻帧中获取更多的信息并进行重建。得益于深度特征提取块和融合模块,本文方法相对于其他多帧方法能恢复更加干净、清晰的画面,从而明显改善压缩帧的主观质量。

图5 测试集主观对比结果

此外,为了进一步验证本文方法及各模块的有效性,对模型进行了消融实验,其客观指标见表2。可以发现,本文提出的深度特征提取块和融合模块均对图像重建产生一定增益,且在组合训练时产生了最好效果,验证了模型的合理性。

表2 模块消融结果(dB)

不同于单帧方法,多帧方法提取多个帧的信息用于重建,不同数量的输入帧会给模型性能带来影响。表3给出了不同数量输入对模型性能产生的增益,可以发现,增大输入帧时间跨步可以提高重建结果的质量,但同时也增大了计算量,出于性能和计算量的平衡,本文采用5帧输入的方案。

值得一提的是,训练数据基本由单一场景视频构成,但在实际测试和使用中,视频中不可避免会遇到少量的场景转换。实验发现,本文逐步融合模块可以相对更好地感知帧间差异,聚焦对重建结果更有益的相邻特征,从而高效利用时序信息。图6给出某一测试中存在场景转换的相邻帧,并列出了本文方法同对比方法的重建结果。通过观察可知,STDF方法在面对场景转换时可出现严重的重叠伪影,该方法对相邻帧同时进行时空特征提取,故在转场时不可避免地引入不同场景的特征。本文方法的空间对齐和时序融合操作虽然是分开进行的,但在未添加融合模块的消融模型中也一定程度出现了重叠情况。相比而言,添加了融合模块的完整模型虽然产生了更大的计算量,但在测试实验中较好地避免了重叠伪影。对于测试涉及场景转换的相邻帧,STDF的平均增益为0.05 dB,而本文方法则为0.31 dB。可以发现,本文方法在场景边缘的重建上带来了更好的性能,这也进一步验证了其带有注意力逐步融合机制的有效性。

图6 融合模块效果对比

本文提出的多帧压缩视频增强网络,能够有效去除压缩视频中的复杂不自然效应。为此,首先提出一种深度特征提取块,输入特征和不同层次的输出分支交叉地进行密集连接,以对输入帧提取丰富的空间信息。其次,为了有效利用不同帧中的时空信息,缓解帧间运动差异,相邻帧特征被成对地投入自适应偏移网络学习运动偏移并通过DCN进行隐式对齐。同时,为了进一步利用多个帧中的时间信息感知质量差异,本文还提出了一种带有通道注意力的逐步融合模块,带有丰富时间信息的多通道特征被分组提取,使得网络关注重要的时间信息。最后,带有时空信息的融合特征被送入多个深度特征块,进行进一步的质量增强。在公开测试集上,本文方法在客观指标(PSNR/SSIM)和主观表现上实现了明显提升,恢复了更高视觉质量的画面。相较其他方法,本文方法在压缩视频增强任务上取得了更优的性能。

但本文方法同诸多对比方法一样具有一定的局限性,在取得明显增强效果的同时也带来了不小的计算负担,无法在低性能设备端达到实时增强,方法的效果与计算平衡性依旧有待挖掘。随着底层视觉领域的不断发展和推进,在后续的研究中将持续探索方法的轻量化和更广地应用场景,在结构和效率方面不断优化,追求达到更优的性能。

[1] Wien M. High efficiency video coding[J]. Signals and Communication Technology, 2015, 36(11): 2340-2355.

[2] FOI A, KATKOVNIK V, EGIAZARIAN K. Pointwise shape-adaptive DCT for high-quality denoising and deblocking of grayscale and color images[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2007, 16(5): 1395-1411.

[3] ZHANG X F, XIONG R Q, FAN X P, et al. Compression artifact reduction by overlapped-block transform coefficient estimation with block similarity[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2013, 22(12): 4613-4626.

[4] ZHAO Y, JIA W, LI L, et al. Filtered mapping-based method for compressed web image super-resolution[J]. IEEE Access, 2017, 5: 12682-12695.

[5] DONG C, DENG Y B, LOY C C, et al. Compression artifacts reduction by a deep convolutional network[C]//2015 IEEE International Conference on Computer Vision. New York: IEEE Press, 2015: 576-584.

[6] TAI Y, YANG J, LIU X M, et al. MemNet: a persistent memory network for image restoration[C]//2017 IEEE International Conference on Computer Vision. New York: IEEE Press, 2017: 4549-4557.

[7] ZHANG Y L, LI K P, K L, et al. Residual non-local attention networks for image restoration[EB/OL]. (2019-03-24) [2021- 11-23]. https://arxiv.org/abs/1903.10082.

[8] YANG R, XU M, WANG Z L, et al. Multi-frame quality enhancement for compressed video[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2018: 6664-6673.

[9] GUAN Z Y, XING Q L, XU M, et al. MFQE 2.0: a new approach for multi-frame quality enhancement on compressed video[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(3): 949-963.

[10] CABALLERO J, LEDIG C, AITKEN A, et al. Real-time video super-resolution with spatio-temporal networks and motion compensation[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2017: 2848-2857.

[11] XUE T F, CHEN B A, WU J J, et al. Video enhancement with task-oriented flow[J]. International Journal of Computer Vision, 2019, 127(8): 1106-1125.

[12] DENG J N, WANG L, PU S L, et al. Spatio-temporal deformable convolution for compressed video quality enhancement[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 10696-10703.

[13] DAI J F, QI H Z, XIONG Y W, et al. Deformable convolutional networks[C]//2017 IEEE International Conference on Computer Vision. New York: IEEE Press, 2017: 764-773.

[14] JANCSARY J, NOWOZIN S, ROTHER C. Loss-specific training of non-parametric image restoration models: a new state of the art[C]//2012 European Conference on Computer Vision. Heidelberg: Springer, 2012: 112-125.

[15] CHANG H B, NG M K, ZENG T Y. Reducing artifacts in JPEG decompression via a learned dictionary[J]. IEEE Transactions on Signal Processing, 2014, 62(3): 718-728.

[16] ZHANG K, ZUO W M, CHEN Y J, et al. Beyond a Gaussian denoiser: residual learning of deep CNN for image denoising[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2017, 26(7): 3142-3155.

[17] MITTAL A, MOORTHY A K, BOVIK A C. No-reference image quality assessment in the spatial domain[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2012, 21(12): 4695-4708.

[18] TIAN Y P, ZHANG Y L, FU Y, et al. TDAN: temporally- deformable alignment network for video super-resolution[C]// 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2020: 3357-3366.

[19] WANG X T, CHAN K C K, YU K, et al. EDVR: video restoration with enhanced deformable convolutional networks[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. New York: IEEE Press, 2019: 1954-1963.

[20] ZHU X Z, HU H, LIN S, et al. Deformable ConvNets V2: more deformable, better results[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2019: 9300-9308.

[21] KAPPELER A, YOO S, DAI Q Q, et al. Video super-resolution with convolutional neural networks[J]. IEEE Transactions on Computational Imaging, 2016, 2(2): 109-122.

[22] KIM S Y, LIM J, NA T, et al. Video super-resolution based on 3D-CNNS with consideration of scene change[C]//2019 IEEE International Conference on Image Processing. New York: IEEE Press, 2019: 2831-2835.

[23] DOSOVITSKIY A, FISCHER P, ILG E, et al. FlowNet: learning optical flow with convolutional networks[C]//2015 IEEE International Conference on Computer Vision. New York: IEEE Press, 2015: 2758-2766.

[24] WANG Q L, WU B G, ZHU P F, et al. ECA-net: efficient channel attention for deep convolutional neural networks[C]// 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2020: 11531-11539.

[25] OHM J R, SULLIVAN G J, SCHWARZ H, et al. Comparison of the coding efficiency of video coding standards—including high efficiency video coding (HEVC)[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2012, 22(12): 1669-1684.

[26] SULLIVAN G J, OHM J R, HAN W J, et al. Overview of the high efficiency video coding (HEVC) standard[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2012, 22(12): 1649-1668.

[27] LAI W S, HUANG J B, AHUJA N, et al. Deep Laplacian pyramid networks for fast and accurate super-resolution[C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2017: 5835-5843.

Multi-frame compressed video enhancement based on spatio-temporal fusion

MA Yan-bo1, LI Lin1, CHEN Yuan1, ZHAO Yang1, HU Rui2

(1. School of Computer Science and Information Engineering, Hefei University of Technology, Hefei Anhui 230601, China; 2. Information Construction and Management Center, Suzhou University of Science and Technology, Suzhou Jiangsu 215009, China)

In order to reduce the storage and transmission cost of video, lossy compression is in frequent use, which however would incur various types of artifacts in the video and affect users’ subjective visual experience. The single frame method cannot be directly applied to video processing, because they independently process each video frame, limiting the use of spatial information and causing limited effectiveness. Inter-frame alignment or temporal structure was often adopted in multi-frame methods to enhance the reconstruction results by utilizing the temporal information, but there remains much room for improvement in alignment performance. To solve the above problems, a multi-frame spatio-temporal compression artifact removal method was proposed to achieve better alignment fusion through the alignment fusion design. This method efficiently utilized the multi-frame spatio-temporal information to reconstruct high quality videos.The experimental results show that the proposed method outperforms other comparative methods on a number of test compressed videos with different resolutions (HM16.5 under low delay P), and that it can achieve an average improvement of 0.13 dB on the objective index peak signal to noise ratio (PSNR) compared with the state-of-the-art multi-frame method STDF. Meanwhile, the proposed method can yield promising results in subjective comparisons, reconstructing a clearer picture with a good effect of compression artifact removal.

compressed image restoration; block effect removal; video enhancement; multi-frame alignment fusion;deformable convolution

23 November,2021;

Key R&D and Transformation Program of Qinghai Province (2021-GX-111); National Natural Science Foundation of China (61972129); Natural Science Research Projects of Colleges and Universities in Jiangsu Province (20KJB520013)

MA Yan-bo (1997-), master student. His main research interests cover image processing and computer vision. E-mail:ybma@mail.hfut.edu.cn

TP 751.1

10.11996/JG.j.2095-302X.2022040651

A

2095-302X(2022)04-0651-08

2021-11-23;

2022-02-24

24 February,2022

青海省科技重点研发与成果转化专项(2021-GX-111);

国家自然科学基金项目(61972129);

江苏省高等学校自然科学研究项目(20KJB520013)

马彦博(1997-),男,硕士研究生。主要研究方向为计算机视觉与图像处理。E-mail:ybma@mail.hfut.edu.cn

赵 洋(1987-),男,副研究员,博士。主要研究方向为图像处理、计算机视觉等。E-mail:yzhao@hfut.edu.cn

ZHAO Yang (1987-), associate researcher, Ph.D. His main research interests cover image processing, computer vision, etc. E-mail:yzhao@hfut.edu.cn

猜你喜欢 特征提取卷积特征 根据方程特征选解法中学生数理化·中考版(2022年9期)2022-10-25离散型随机变量的分布列与数字特征中学生数理化(高中版.高考数学)(2022年3期)2022-04-26基于3D-Winograd的快速卷积算法设计及FPGA实现北京航空航天大学学报(2021年9期)2021-11-02卷积神经网络的分析与设计电子制作(2019年13期)2020-01-14空间目标的ISAR成像及轮廓特征提取北京航空航天大学学报(2019年9期)2019-10-26基于Gazebo仿真环境的ORB特征提取与比对的研究电子制作(2019年15期)2019-08-27基于特征提取的绘本阅读机器人设计方案电子制作(2019年15期)2019-08-27从滤波器理解卷积电子制作(2019年11期)2019-07-04不忠诚的四个特征当代陕西(2019年10期)2019-06-03基于Daubechies(dbN)的飞行器音频特征提取电子制作(2018年19期)2018-11-14本文来源:http://www.zhangdahai.com/shiyongfanwen/qitafanwen/2023/0713/624701.html